Soluciones para validar integridad de datos en pipelines ETL: Guía completa para garantizar la calidad de información

¿Qué es la validación de integridad de datos en pipelines ETL?

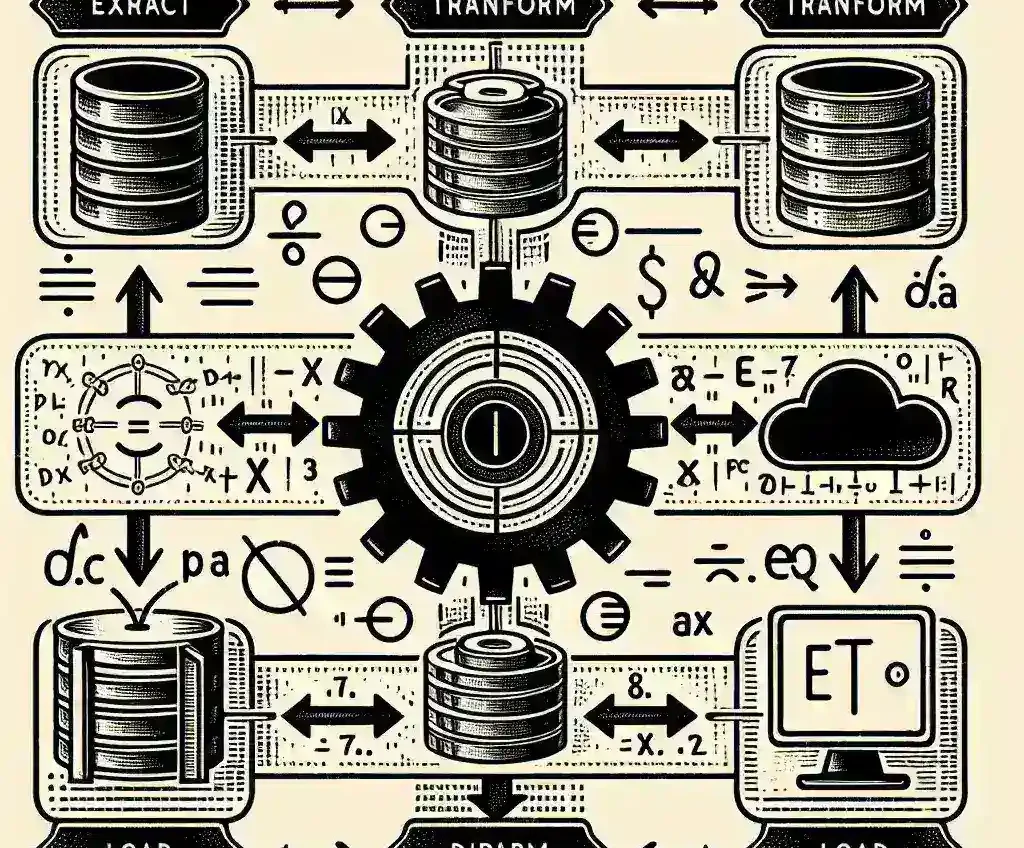

La validación de integridad de datos en procesos ETL (Extract, Transform, Load) representa uno de los pilares fundamentales para asegurar la calidad y confiabilidad de la información que fluye a través de nuestros sistemas de datos. En un mundo donde las organizaciones procesan volúmenes masivos de información diariamente, garantizar que estos datos mantengan su precisión, completitud y consistencia durante todo el proceso de transformación se ha convertido en una necesidad crítica.

Los pipelines ETL actúan como autopistas de datos, transportando información desde múltiples fuentes hacia destinos específicos, aplicando transformaciones complejas en el camino. Sin embargo, como cualquier autopista, pueden surgir «accidentes» que comprometan la integridad de la carga que transportan. Estos accidentes pueden manifestarse como datos duplicados, valores nulos inesperados, inconsistencias de formato o pérdida de información durante las transformaciones.

Principales desafíos en la validación de datos ETL

Los profesionales de datos enfrentan múltiples obstáculos al implementar sistemas de validación efectivos. Uno de los principales desafíos radica en la heterogeneidad de las fuentes de datos. Las organizaciones modernas extraen información de bases de datos relacionales, archivos CSV, APIs REST, sistemas legacy y plataformas en la nube, cada una con sus propios formatos y estándares de calidad.

La escalabilidad presenta otro reto significativo. Mientras que validar pequeños conjuntos de datos puede realizarse manualmente o con scripts simples, los volúmenes empresariales requieren soluciones automatizadas capaces de procesar terabytes de información sin comprometer el rendimiento del sistema.

Además, la naturaleza dinámica de los esquemas de datos modernos complica la implementación de reglas de validación estáticas. Los sistemas deben adaptarse a cambios en la estructura de datos sin interrumpir los procesos críticos de negocio.

Impacto de datos incorrectos en el negocio

Las consecuencias de datos comprometidos trascienden el ámbito técnico, impactando directamente en la toma de decisiones estratégicas. Estudios recientes indican que las organizaciones pierden aproximadamente el 12% de sus ingresos anuales debido a decisiones basadas en información incorrecta o incompleta.

Estrategias fundamentales para la validación de integridad

Validación en tiempo de extracción

La primera línea de defensa contra datos comprometidos se establece durante la fase de extracción. Implementar controles de calidad inmediatos permite identificar problemas en su origen, reduciendo significativamente los costos de corrección posterior.

Los checksums y hashes criptográficos proporcionan una manera eficiente de verificar que los datos no hayan sido alterados durante la transferencia. Estas técnicas matemáticas generan «huellas digitales» únicas para cada conjunto de datos, permitiendo detectar cualquier modificación no autorizada.

Validación durante la transformación

Durante las transformaciones, los datos experimentan cambios estructurales y de contenido que requieren validaciones específicas. Las reglas de negocio deben implementarse como filtros inteligentes que evalúen la lógica y coherencia de la información procesada.

Por ejemplo, en un sistema financiero, una regla podría verificar que el saldo de una cuenta nunca sea negativo después de aplicar una transacción, o que las fechas de vencimiento sean posteriores a las fechas de emisión en documentos comerciales.

Validación pre-carga

Antes de cargar los datos en el sistema destino, una validación final asegura que toda la información cumple con los estándares requeridos. Esta etapa incluye verificaciones de integridad referencial, donde se confirma que las relaciones entre entidades permanezcan intactas.

Herramientas y tecnologías especializadas

Soluciones de código abierto

El ecosistema de herramientas open source ofrece alternativas robustas para organizaciones con presupuestos limitados. Apache Griffin se destaca como una plataforma especializada en validación de calidad de datos, proporcionando métricas en tiempo real sobre la salud de los pipelines ETL.

Great Expectations ha ganado popularidad por su enfoque declarativo para definir expectativas sobre los datos. Los desarrolladores pueden especificar reglas como «esta columna nunca debe contener valores nulos» o «los valores deben estar dentro de un rango específico», y la herramienta automáticamente valida estas condiciones.

Plataformas empresariales

Para organizaciones que requieren capacidades avanzadas, soluciones como Informatica Data Quality o Talend Data Fabric ofrecen funcionalidades empresariales que incluyen perfilado automático de datos, detección de anomalías mediante machine learning y dashboards ejecutivos para monitorear la salud general de los datos.

Estas plataformas integran capacidades de data lineage, permitiendo rastrear el origen y transformaciones de cada elemento de datos a través de todo el pipeline, facilitando la identificación rápida de problemas cuando surgen inconsistencias.

Implementación de controles de calidad automatizados

Diseño de reglas de validación escalables

La efectividad de un sistema de validación depende en gran medida del diseño de reglas que sean tanto comprehensivas como eficientes computacionalmente. Las reglas deben organizarse en niveles de criticidad, donde violaciones menores generen alertas sin detener el proceso, mientras que errores críticos interrumpan inmediatamente la ejecución.

Un enfoque efectivo consiste en implementar validaciones en cascada, donde controles básicos como verificación de tipos de datos se ejecutan primero, seguidos por validaciones más complejas que requieren mayor procesamiento.

Monitoreo continuo y alertas inteligentes

Los sistemas modernos de validación incorporan capacidades de monitoreo proactivo que aprenden patrones normales de datos y alertan cuando se detectan desviaciones significativas. Estos sistemas utilizan algoritmos de detección de anomalías para identificar problemas sutiles que podrían pasar desapercibidos con reglas estáticas.

Las alertas inteligentes clasifican automáticamente los problemas según su impacto potencial, enviando notificaciones inmediatas para errores críticos mientras que agrupan problemas menores en reportes periódicos para evitar la fatiga de alertas.

Mejores prácticas para equipos de datos

Establecimiento de estándares organizacionales

La implementación exitosa de validación de integridad requiere el establecimiento de estándares claros y consistentes a nivel organizacional. Estos estándares deben definir formatos de datos aceptables, reglas de nomenclatura, tolerancias de calidad y procedimientos de escalación cuando se detectan problemas.

La documentación exhaustiva de estos estándares facilita la incorporación de nuevos miembros del equipo y asegura que todos los stakeholders compartan una comprensión común de los requisitos de calidad de datos.

Cultura de calidad de datos

Más allá de las herramientas tecnológicas, el éxito en la validación de integridad depende del desarrollo de una cultura organizacional que valore la calidad de datos. Esto implica entrenar a todos los usuarios de datos sobre la importancia de la integridad, establecer métricas de calidad como KPIs departamentales y reconocer públicamente los esfuerzos por mantener altos estándares de datos.

Tendencias futuras en validación de datos

El futuro de la validación de integridad de datos apunta hacia la automatización inteligente impulsada por inteligencia artificial. Los sistemas emergentes utilizan machine learning para aprender automáticamente patrones de datos y generar reglas de validación dinámicas que se adaptan a cambios en los esquemas y contenido de datos.

La integración con tecnologías de streaming permitirá validaciones en tiempo real para datos que fluyen continuamente, mientras que las capacidades de self-healing automáticamente corregirán problemas comunes sin intervención humana.

Además, la adopción creciente de arquitecturas de datos distribuidas impulsa el desarrollo de soluciones de validación que pueden operar eficientemente en entornos multi-nube y hybrid, manteniendo la consistencia de datos a través de múltiples plataformas y geografías.

Conclusión

La validación de integridad de datos en pipelines ETL representa un componente esencial para el éxito de cualquier iniciativa de datos empresarial. Las organizaciones que invierten en implementar soluciones robustas de validación no solo protegen la calidad de su información, sino que también construyen la base para decisiones de negocio más acertadas y confiables.

El panorama tecnológico continúa evolucionando, ofreciendo herramientas cada vez más sofisticadas para abordar los desafíos de validación de datos. Sin embargo, el factor humano permanece crucial: la combinación de tecnología avanzada con equipos bien entrenados y procesos bien definidos constituye la fórmula para el éxito en la gestión de integridad de datos.

Las organizaciones que adopten un enfoque proactivo hacia la validación de datos, implementando controles automatizados y fomentando una cultura de calidad, estarán mejor posicionadas para aprovechar el valor completo de sus activos de información en la era digital.